近日,实验室关于分割模型鲁棒结构设计的工作“Towards Robust Semantic Segmentation against Patch-based Attack via Attention Refinement” (作者: 袁峥,张杰*,王愚德,山世光,陈熙霖) 被IJCV接收。IJCV全称为International Journal of Computer Vision, 是计算机视觉领域的国际主流期刊, 2022年公布的影响因子为19.5。

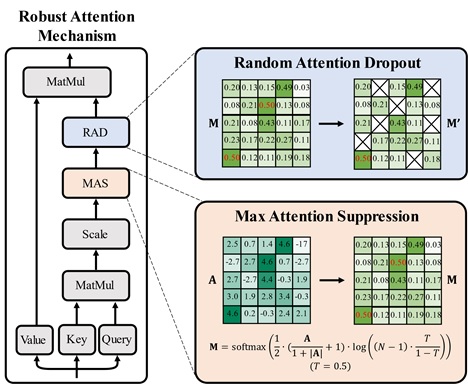

近年来,注意力机制在各种视觉任务中都展现出了良好的效果。在语义分割任务中,注意力机制也被广泛应用于不同方法中,包括基于卷积神经网络(CNN)和视觉变压器(ViT)作为主干网络的模型。然而,我们观察到注意力机制容易受到基于补丁的对抗攻击的影响。通过对有效感受野的分析,我们发现这种现象可以归因于全局注意力带来的更广泛的感受野,进而扩散了对抗补丁带来的影响。为了解决这一问题,本文提出了一种鲁棒注意力机制(Robust Attention Mechanism, RAM)以提高语义分割模型的鲁棒性,从而显著缓解基于补丁的对抗攻击的影响。与传统注意力机制相比,RAM引入了两个新颖的模块,即最大注意力抑制(Max Attention Suppression, MAS)和随机注意力丢弃(Random Attention Dropout, RAD)。这两个模块旨在改进注意力矩阵,限制单个对抗补丁对其他位置语义分割结果的影响。大量的实验证明了我们的RAM方法在不同攻击设置下显著增强了语义分割模型对各种基于补丁的攻击方法的鲁棒性。

图 1: 鲁棒注意力机制(RAM)的结构图,包含最大注意力抑制(MAS)和随机注意力丢弃(RAD)两个模块

附件下载: