近日,实验室关于基于语言描述的行人检索的工作被IEEE TIP接收。TIP的全称为Transactions on Image Processing,是计算机视觉和图像处理领域的国际期刊之一,2020年SCI影响因子为6.79。论文信息:

Yucheng Chen, Rui Huang, Hong Chang, Chuanqi Tan, Tao Xue and Bingpeng Ma. “Cross-Modal Knowledge Adaptation for Language-Based Person Search”, IEEE Transactions on Image Processing (TIP), 2021. (Accepted)

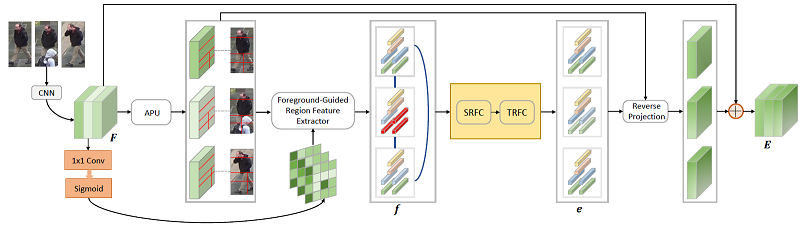

基于语言描述的行人检索是一个具有挑战性的检索任务,不同模态的信息不一致使得直接衡量视觉图片和文本描述的相似度较为困难。当前共同表示学习方法以一种均等的方式将图片特征和文本特征投影到共同空间中。但是,图片和文本所包含的信息事实上是不均等的。例如,由于文本是对图片中行人身份的一段描述,它总结的是部分图片信息。而图片则包含了一些很少被文本所描述的,与行人身份无关的信息。图片和文本的这种信息量不平衡造成图片的信息冗余,和不同模态间特征的对齐困难,不利于学习细粒度的文本-视觉对应关系。考虑到文本可用于指导图片特征使其关注重要的行人细节,并去除图片身份无关信息的干扰,本文提出了一种跨模态知识适应的方法。具体的,本工作在三个不同层级上进行文本到图片的指导:个体、排序和类别。通过结合这些层级的知识适应,图片中与身份无关的信息被抑制,图片和文本的共同空间被更好地建立。跨模态知识适应的总体框架图如下:

总体而言,本工作的主要贡献包括:1)提出了跨模态知识适应,平衡图片模态和文本模态的信息量,更好地学习文本-视觉对应关系;2)在基于语言描述的行人检索数据集上验证了跨模态知识适应的有效性;3)验证了跨模态知识适应在不同检索任务(包括通用图文匹配,行人图片检索语言描述)上的有效性。

附件下载: