近日,实验室5篇论文被CVPR 2022接收。CVPR的全称是IEEE Conference on Computer Vision and Pattern Recognition,是计算机视觉和模式识别领域的顶级会议。5篇论文的信息概要介绍如下:

1. Salient-to-Broad Transition for Video Person Re-identification. (Shutao Bai, Bingpeng Ma, Hong Chang, Rui Huang and Xilin Chen)

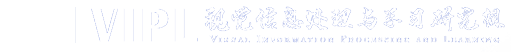

在视频行人再识别中,现有方法往往不能充分的利用视频中的时序关系,这使得每帧的注意力区域仅仅能关注到局部的信息,并且不同帧之间的注意力区域过于相似。针对这一问题,我们提出了一个显著到广泛(Salient-to-Broad)模块用以逐渐扩大注意力区域,并最终涵盖行人全部的前景区域,从而得到行人的完整特征表述。具体地,当前面的一些帧已经关注到最显著的区域后,该模块会促使后面的帧关注到更广泛的区域。通过这种方式,广泛区域的信息可以对显著区域进行补充,从而得到更全面且更具辨识性的行人特征。进一步地,我们提出了一个聚合-分配(Integration-and-Distribution)模块来增强帧级别的特征表示。该模块首先从整个特征空间中聚合出一些关键特征,然后将这些特征分配到每个位置上,从而建模时空维度上的长距依赖关系。本文提出的这两个模块分别在视频层次和帧层次上增强了行人特征,具有一定的互补性。我们在四个常用的数据集上做了大量实验,实验证明了我们提出方法的有效性和优越性。

图1. 显著到广泛(Salient-to-Broad)模块的整体架构

2. Clothes-Changing Person Re-identification with RGB Modality Only. (Xinqian Gu, Hong Chang, Bingpeng Ma, Shutao Bai, Shiguang Shan and Xilin Chen)

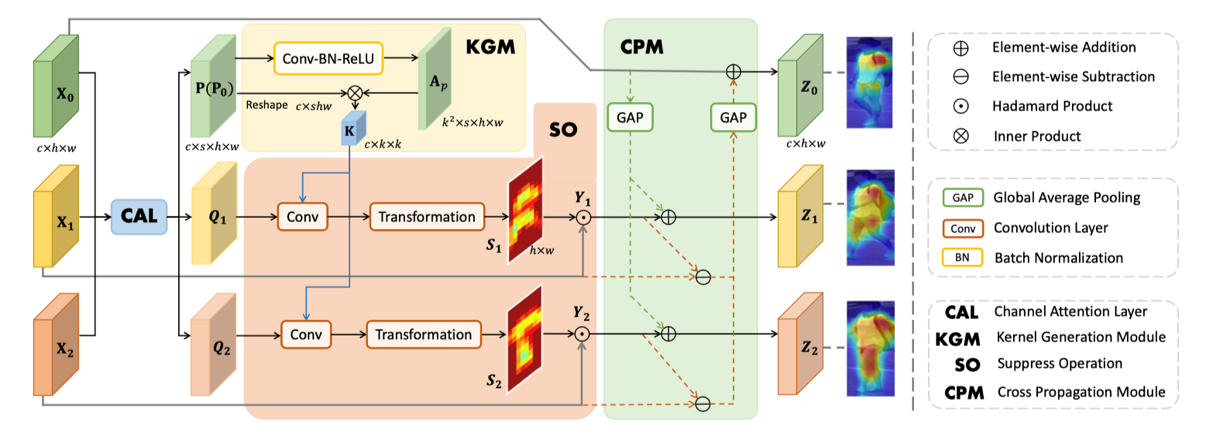

解决换衣行人再识别的关键是提取衣服无关的特征,比如:人脸、发型、体型和步态特征等。当前大多数换衣行人再识别相关方法主要关注于从多模态信息(如:轮廓或草图)中建模体型特征,但是这些方法并没有充分利用原始RGB模态的衣服无关信息。本文提出一种基于衣服的对抗损失,通过惩罚行人再识别模型对衣服的判别能力来充分挖掘原始RGB图像中的衣服无关特征。大量的实验表明在仅使用RGB输入的情况下本文的方法在几个常用的换衣行人再识别数据集上均优于现有的最优模型。另外,和图像相比,视频中包含了丰富的表观和额外的时序信息。这些信息可以被用来建模时空特征以作为静态图像特征的补充来协助换衣行人再识别。由于目前没有公开可用的基于视频的换衣行人再识别数据集,本文构建了一个新的基于视频的换衣行人再识别数据集(CCVID)并通过大量的实验展示了换衣行人再识别在时空信息建模方面还有很大的提升空间。

图2. 方法框架图。在训练阶段的每次迭代中,首先通过最小化衣服分类损失来优化衣服分类器;接着通过最小化识别损失和基于衣服的对抗损失迫使骨干网络挖掘衣服无关特征。

3. Automatic Relation-aware Graph Network Proliferation. (Shaofei Cai, Liang Li, Xinzhe Han, Jiebo Luo, Zhengjun Zha and Qingming Huang)

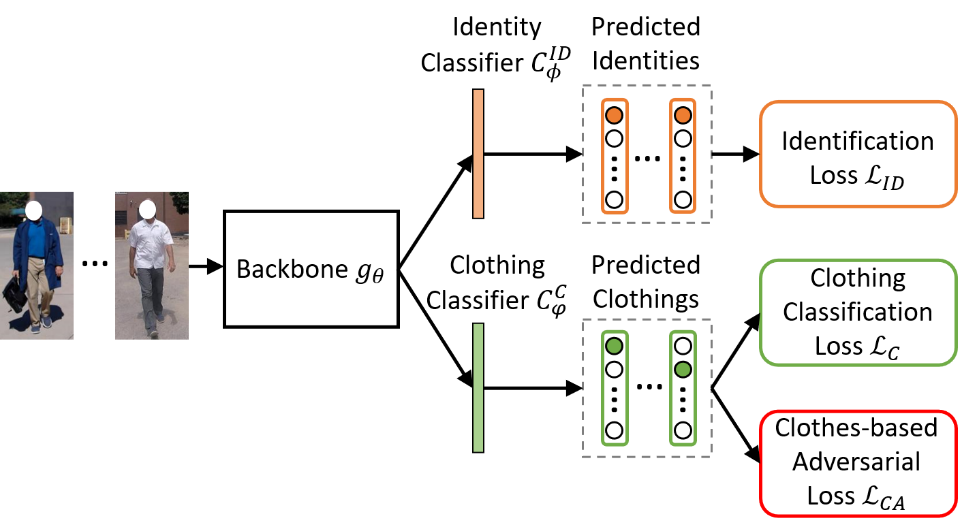

随着图神经网络(GNN)在许多关系任务中表现出强大的推理能力,图神经结构搜索引起了人们的广泛关注。然而,目前使用的图网络搜索空间过于强调节点特征的学习,而忽略了对层次关系信息的挖掘。此外,由于消息传递机制的多样性,图网络搜索空间比CNN大得多。这就阻碍了经典搜索策略在复杂图网络搜索空间中的直接应用。我们提出了一种关系感知图神经网络的自动增殖算法(ARGNP),来高效地搜索具有关系引导消息传递机制的图网络模型。具体来说,我们首先设计了一个新的对偶式关系感知的图网络搜索空间,它包含节点和关系学习操作。这些操作可以提取层次节点/关系信息,并为图上的消息传递提供各向异性的指导。其次,受细胞增殖的启发,我们设计了一个网络增殖搜索范式,通过迭代执行网络分裂和网络分化操作,逐步确定目标的GNN架构。在6个数据集上对4个图学习任务的实验表明,我们的方法生成的GNN优于目前最先进的手工制作和基于搜索的GNN。

4. Few Shot Generative Model Adaption via Relaxed Spatial Structural Alignment. (Jiayu Xiao, Liang Li, Chaofei Wang, Zhengjun Zha and Qingming Huang)

使用少样本训练对抗生成网络(GAN)一直是一个挑战性任务。一个可行的方式是在一个在大规模源域数据上训练好的GAN模型的基础上,将其迁移到少样本目标域——这种方法即为少样本生成模型迁移。然而,现有方法在极少样本(少于10)的条件下,很容易造成模型的过拟合和模式坍缩。为了解决这一问题,我们提出了一种松弛化的空间结构一致性对齐方法来在迁移过程中对目标域生成模型进行校正。我们设计了一种跨域结构一致性损失,由自相关和扰动相关一致性损失组成。它可以用来帮助对齐源域和目标域的生成对的空间结构信息。为了松弛化这个跨域对齐操作,我们将原始的隐空间压缩至一个更加靠近目标域的子空间内,以此来拉进生成的源域、目标域图像对之间的距离。我们进一步设计了一种评价指标来从空间结构的角度量化图片的生成质量,这个指标可以作为目前的评价指标的一种补足替代。定性和定量结果表明我们的方法在少样本设定下一致性地超越了当前最优方法。

5. Enhancing Face Recognition with Self-Supervised 3D Reconstruction. (Mingjie He, Jie Zhang, Shiguang Shan and Xilin Chen)

为了提升人脸识别在复杂光照和姿态条件下的精度,本文提出了一种自监督三维重构旁路网络来提升人脸识别骨干网络对身份相关的人脸深度信息和人脸反射率信息的感知能力。该旁路网络从人脸识别骨干网络的中间层特征中解码出人脸图像的三维深度图和二维反射率图,并和从输入图像上估计的人脸姿态信息和光照信息一起,通过光照模型、成像模型及可微分渲染模块来重构的二维人脸图像。使用重构损失函数和人脸识别的分类损失函数来联合训练人脸识别骨干网络以及旁路网络,进而强化人脸识别特征。在训练过程中,上述自监督三维重构任务作为一种正则化来约束人脸识别骨干网络去感知更多的三维人脸信息,从而有利于提升复杂场景下的人脸识别精度。本方法在多个人脸识别测试集上取得了当前最好的效果。此外,本方法训练获得的人脸识别骨干网络也为解决小样本人脸属性识别提供了良好的基础模型。

附件下载: