近日,实验室关于视频行人再识别和目标检测的工作先后被IEEE TIP接收。IEEE TIP的全称为IEEE Transactions on Image Processing,是计算机视觉和图像处理领域的顶级国际期刊之一,2021年SCI影响因子为10.856。两篇论文信息如下:

1. Motion Feature Aggregation for Video-based Person Re-identification (Xinqian Gu, Hong Chang, Bingpeng Ma and Shiguang Shan)

当前大多数视频行人再识别相关方法只关注于表观特征,却忽略了运动特征。事实上,运动特征可以帮助区分那些仅用表观特征难以区分的目标行人。然而当前大多数时序信息建模方法很难有效且高效地为视频行人再识别任务提取运动特征。因此本文提出了一个更高效的运动特征整合的方法以在特征图层面建模和整合运动信息。具体来讲,所提出的方法包含两个模块:1)粗粒度运动学习模块( coarse-grained motion learning module,CGML),该模块基于各个身体部件在时间维度上的位置变化提取粗粒度的运动特征;2)细粒度运动学习模块 ( fine-grained motion learning module,FGML),该模块基于各个身体部件在时间维度上的表观变化提取细粒度的运动特征。这两个模块可以从不同粒度提取运动特征,且可以很容易的整合到现有的网络框架中以同时建模表观和运动信息。该方法的示意图如下所示:

图1 运动特征整合方法示意图

总体而言,本工作的主要贡献如下:1)反思了现有的时序信息建模方法对于运动特征提取的有效性和效率问题;2)提出了可以在特征图层面高效建模运动信息的运动特征整合方法;3)证实了所提出方法提取的运动特征是表观特征的重要补充,尤其在一些光照变化很大的情况下有更好的表现;4)在多个视频行人再识别数据集上取得了当前最好性能。

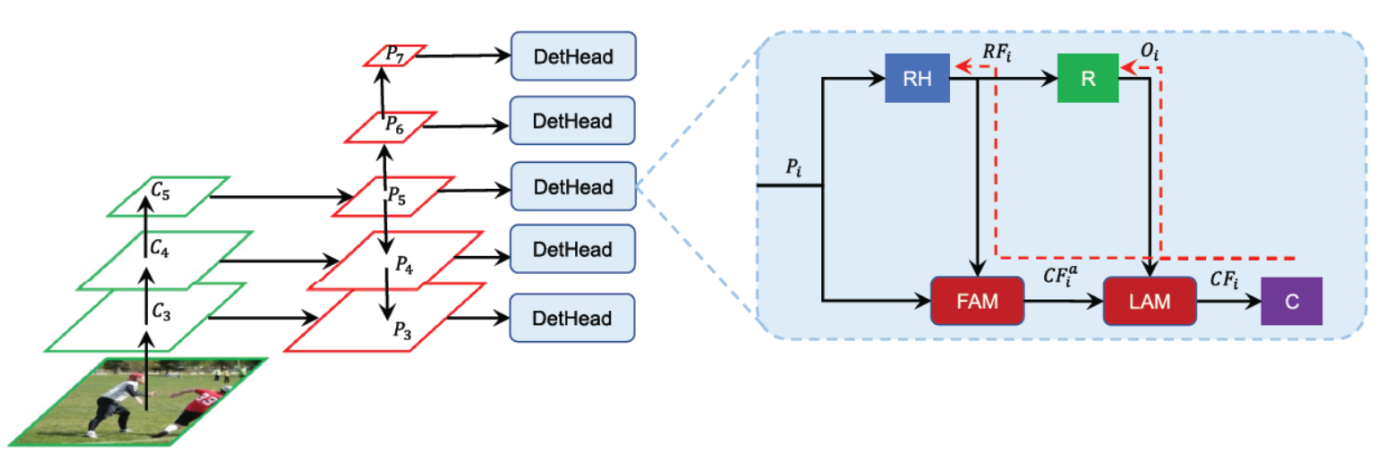

2. Interactive regression and classification for dense object detector (Linmao Zhou, Hong Chang, Bingpeng Ma and Shiguang Shan)

在目标检测中,使用局部信息增强特征表示是提升检测性能的关键手段。但是,由回归分支捕捉到的局部信息(即回归特征和回归补偿)仍没有被充分利用。在这篇文章中,作者提出了一种简单而有效的方法——交互式回归和分类(Interactive Regression and Classification, IRC),来更好的利用局部信息。特别地,通过特征聚合模块(Feature Aggregation Module, FAM)和局部注意力模块(Localization Attention Module, LAM)在前向传播中将局部信息引入到分类分支。同时,分类器在反向传播中指导回归分支的学习,以此保证局部信息为回归和分类所充分利用。因此,回归和分类分支以一种交互的形式进行训练。图2是该方法的示意图。该方法能够很容易地整合到anchor-based和anchor-free的目标检测器中,无需增加计算开销。很多流形的稠密目标检测器(包括RetinaNet, FCOS, ATSS, PAA, GFL, GFLV2, OTA, GA-RetinaNet, RepPoints, BorderDet和VFNet)应用了本文的方法之后可以显著提高其检测性能。基于ResNet-101骨干网络,本文的方法在COCO test-dev上取得了47.2% AP,超越了之前性能优越的PAA(44.8% AP)和GFL(45.0% AP)方法,而且其训练和测试均非常高效。此外,本文的最佳模型(Res2Net-101-DCN)在单模型单尺度上能够取得51.4%的AP。

图2 回归与分类交互的目标检测模型示意图

附件下载: