实验室今年有6篇论文被ECCV 2022接收,ECCV的全称是European Conference on Computer Vision(欧洲计算机视觉国际会议) ,是计算机视觉三大会议(另外两个是ICCV和CVPR)之一,2022年10月将在以色列特拉维夫召开。

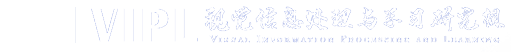

1. Joint Feature Learning and Relation Modeling for Tracking: A One-Stream Framework (Botao Ye, Hong Chang, Bingpeng Ma, and Shiguang Shan)

目前主流的双流目标跟踪框架分别提取模板和搜索区域的特征,然后进行关系建模,因此提取的特征缺乏对目标的认知,导致有限的目标-背景的辨别力。为了解决上述问题,我们提出了一个新颖的单流跟踪框架(OSTrack),它构建了模板-搜索图像对之间的双向信息流,并将特征学习和关系建模统一起来,这使得模型可以通过模板-搜索图像内容的相互引导动态地提取面向目标的判别性特征。此外,得益于高度并行化的结构以及对额外的繁重的关系建模模块的消除,所提出的跟踪器能以很快的速度运行。我们还额外提出了一个基于单流框架所提供的强相似性先验的网络内候选区域早期消除模块,以此进一步地提高了推理效率。OSTrack在多个跟踪基准上取得了最优的性能,实现了良好的性能-速度权衡,并显示出更快的收敛性。

2. Learning Linguistic Association Towards Efficient Text-Video Retrieval (Sheng Fang, Shuhui Wang, Junbao Zhuo, Xinzhe Han, Qingming Huang)

视频-文本检索的主流方式是学习一个用以对齐两个模态的公共空间。因为视频包含比文本更丰富的内容,所以文本描述总是会丢失一些事件或者细节,这使得两个模态的表征很难对齐。我们利用同一视频的不同描述文本之间的互补性,提出了插件式的语言联想框架,如图1所示。具体来说,我们首先训练一个有额外相关描述文本作为输入的教师模型,它通过聚合文本语义获得更丰富的文本表征。然后我们提出了一种适应性的知识蒸馏让学生模型有选择地继承教师模型的能力,以此来抑制教师模型中由于文本聚合而引入的虚假关联。我们在多个不同的数据集和通用方法上应用了我们的框架,均获得了稳定的性能提升,证明了我们方法的有效性。

图 语言联想框架

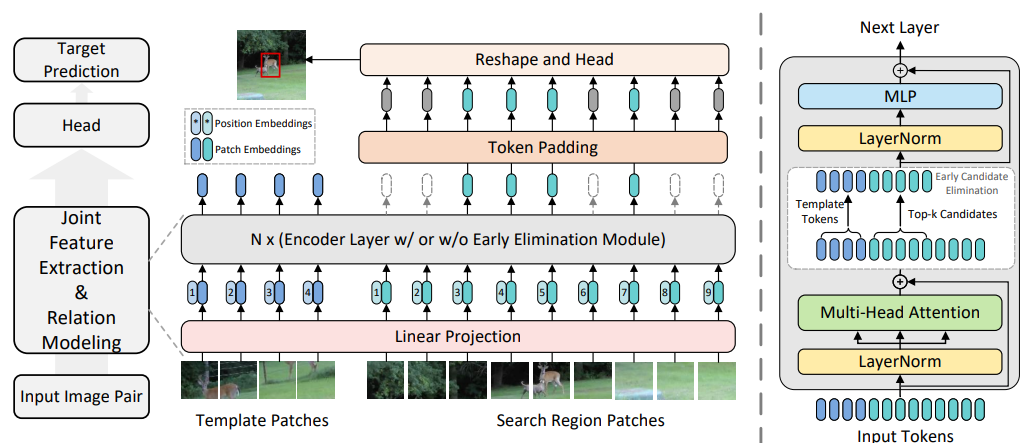

3. Generative Meta-Adversarial Network for Unseen Object Navigation (Sixian Zhang, Weijie Li, Xinhang Song, Yubing Bai, Shuqiang Jiang)

视觉物体导航任务要求智能体自主导航到指定的目标物体,主流的工作关注增强在未知的环境中面向已知物体类别(经过训练的物体类别)的导航能力,并取得了可观的性能。然而这种实验设置很难应用到现实世界中,因为现实世界中包含了无限的物体类别,因而导航到未知物体的情形也是不可避免的。本文关注于在未知环境中面向未知物体类别的视觉物体导航任务,本文的出发点是让智能体根据目标物体语义编码来“想象”目标物体在环境中的视觉特征。本文提出一种由特征生成器和环境元判别器构成的生成式的元对抗网络(GMAN),其中特征生成器可以根据目标物体的语义合成一个初始的特征,环境元判别器则是通过在导航过程中不断收集到的环境信息进一步优化生成器,从而使生成器可以合成更精确的物体特征。生成的特征作为指导信息用于帮助智能体进行物体导航任务。进一步的,为了使生成器能根据有限的观测进行高效的更新,整个对抗网络基于元学习的框架进行优化。本文基于AI2THOR和RoboTHOR模拟器评估了本文的方法,并证明了方法的有效性和优良的性能。

4. Adaptive Image Transformations for Transfer-based Adversarial Attack (Zheng Yuan, Jie Zhang, Shiguang Shan)

对抗样本对于研究深度学习模型的鲁棒性提供了一种很好的视角。基于迁移的黑盒攻击中有一类方法利用若干图像变换操作来提高对抗样本的迁移性。尽管这是一种有效的方法,但是没有考虑输入图像各自的特点。在本工作中,我们提出了一种自适应图像变换学习器(AITL)的新架构,其将不同的图像变换操作融合到统一的框架中,从而可以进一步提高对抗样本的迁移性。不同于现有工作中采用的固定图像变换组合,我们精心设计的变换学习器可以针对不同输入图像的特点,自适应地选择最有效的图像变换组合。ImageNet数据集中的大量实验展示了我们的方法在各种实验设置下,均显著地提高了攻击成功率。

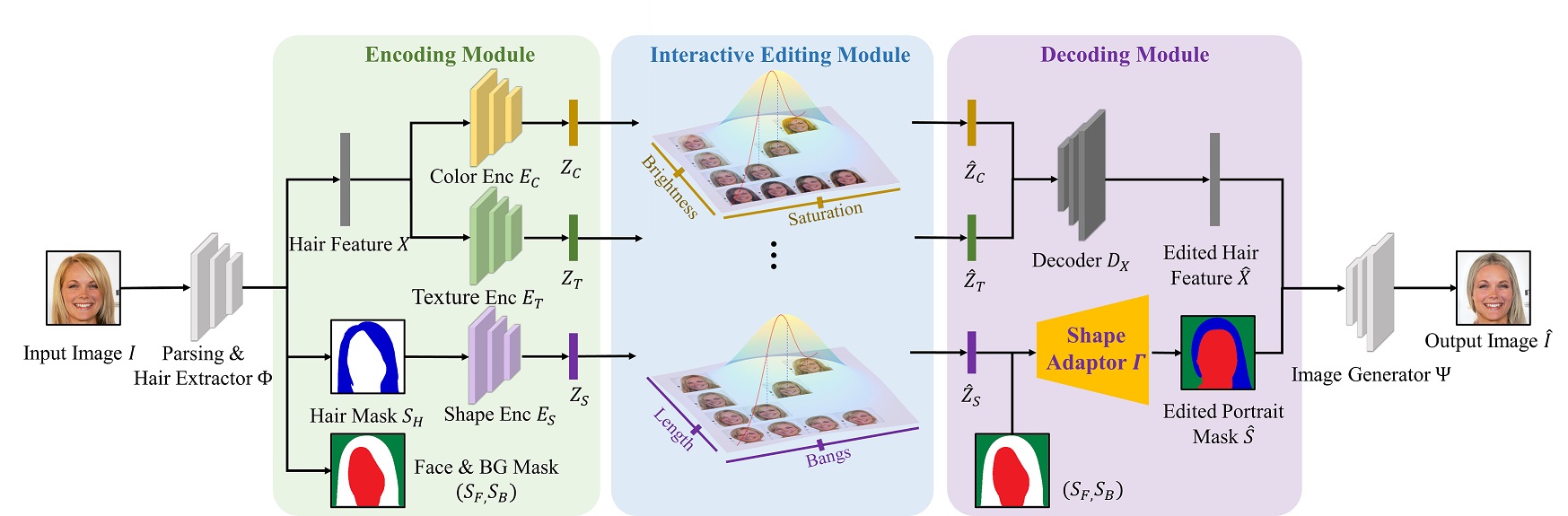

5. GAN with Multivariate Disentangling for Controllable Hair Editing (Xuyang Guo, Meina Kan, Tianle Chen, Shiguang Shan)

头发具有复杂的几何信息和材质,这使得头发编辑成为人像编辑中的一个重要且有难度的任务。现有的编辑方法可以通过给定参考图像、绘制头发分割图或用笔画引导的方式进行编辑。然而,当用户没有提供参考图像、或者头发分割区域很难绘制时,现有方法无法编辑。基于此,我们提出了一种有效的可控编辑方法。该方法可以通过一组滑动控制条,进行连续、细粒度语义的头发编辑。此外,该方法也能很自然地兼容给定参考图像、绘制头发分割图的方式进行编辑。具体地,我们提出了一个具有多元高斯解耦模块的生成对抗网络。首先,通过一个编码器将头发颜色、纹理和形状这三个主要属性进行分解,得到每个属性的隐编码表示。这些隐编码表示被各自建模为标准多元高斯分布,从而使属性的每个维度都可以连续精细地变化。由于隐编码直接服从高斯分布,所以任何通过滑动控制条、给定参考图像、绘制形状分割图的编辑方式都可以支持,这使得和用户之间的交互灵活友好。最后,给定修改后的隐编码表示,解码器输出一个带有编辑后头发的人像。实验表明我们的方法可以连续、单独地编辑每个属性的多个语义维度。

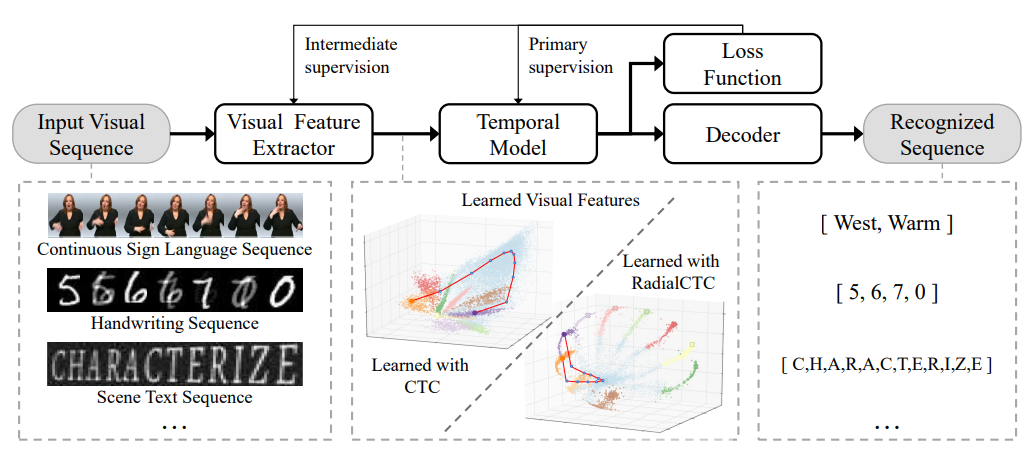

6. Deep Radial Embedding for Visual Sequence Learning (Yuecong Min, Peiqi Jiao, Yannan Li, Xiaotao Wang, Lei Lei, Xiujuan Chai, Xilin Chen)

CTC是序列识别任务中常用的一种损失函数,它采用动态规划的方式迭代地对齐原始输入序列和标签序列,为未分割的输入序列提供监督信号。CTC中的背景类在对齐过程中起到了关键的作用,但也带来了尖峰状的预测结果,使得模型不能准确地提供识别结果的准确位置。本文提出了一种序列识别损失函数RadialCTC,它将特征分布约束在单位超球表面的同时延续使用了CTC的迭代对齐机制。通过RadialCTC训练得到的特征分布在以背景类为极点的径向弧上,这为RadialCTC的训练过程提供了清晰的几何解释,同时也限制了模型的搜索空间进而缓解了过拟合问题。除此之外,RadialCTC通过对背景类的类中心进行扰动,使得预测结果的尖峰状态是可控的,可以在准确识别的同时提供可控的边界信息。在连续手语识别和场景文字识别两个任务上的实验结果表明,本文所提出的RadialCTC可以提供可控的定位结果,并且达到和现有主流方法相当的性能。

附件下载: