近日,实验室关于面部动作单元检测的论文被IEEE T-PAMI期刊接收。IEEE T-PAMI的全称是IEEE Transactions on Pattern Analysis and Machine Intelligence,是CCF推荐的人工智能领域A类期刊,近年影响因子为17.73。论文信息如下:

Yong Li, Jiabei Zeng, Shiguang Shan*. “Learning Representations for Facial Actions from Unlabeled Videos”, IEEE Transactions on Pattern Analysis and Machine Intelligence (TPAMI), 2020. (Accepted)

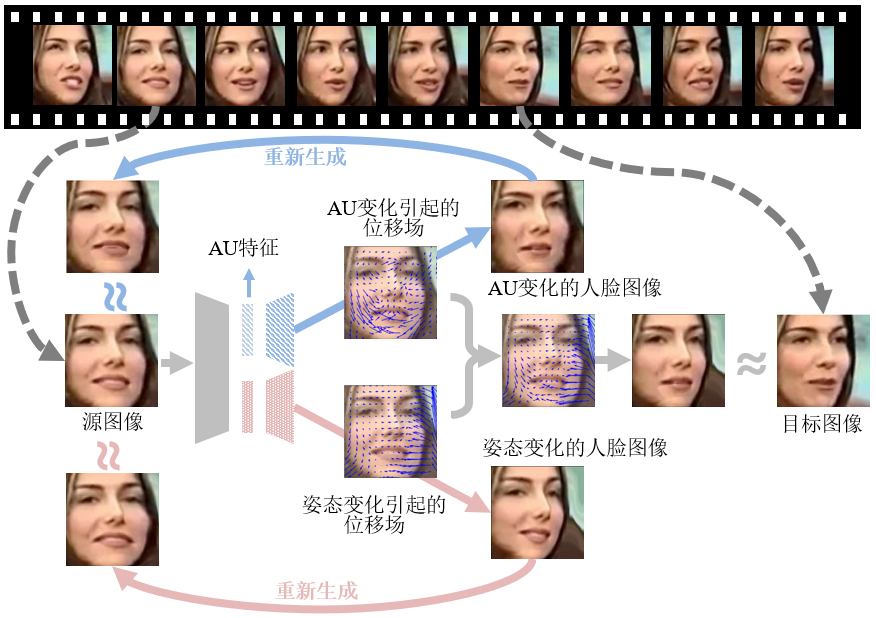

人脸动作编码系统(Facial Action Coding System,简称FACS)从人脸解剖学的角度定义了一组面部动作单元(Action Unit,简称AU),用于描述脸部肌肉运动产生的表观变化,AU的组合可以表达任意人脸表情,近年来受到研究者的广泛关注。然而,AU的标注十分困难,标注不足限制了当前AU检测模型的准确性和泛化性。针对这一问题,本文提出一种基于无标注人脸视频数据的自监督AU特征学习方法。考虑到AU变化引起的表观运动信息存在于一个视频中前后两帧人脸图像(同一个人)的像素运动(位移场)之中,本文以两张图像之间的运动信息为代理监督信号,采用自监督方法学习出AU特征。同时考虑到两帧人脸图像之间的运动同时包含了面部表情变化引入的运动,以及头部姿态引入的运动,本文设计了一个孪生循环自编码网络(Twin-cycle Autoencoder, TAE),以自监督的方式学习出输入人脸图像的AU及姿态特征。该方法框架图如下所示:

总体而言,TAE以随机采样的两帧人脸图像(源图像,目标图像)作为输入,首先编码出两帧图像的AU特征及姿态特征,然后通过独立的解码器分别解码出AU变化,以及头部姿态变化引起的运动(位移场)。通过解码出的AU位移场, TAE 能够基于源图像生成一张和目标图像表情一致,而姿态不变的人脸图像。基于姿态位移场,TAE能够基于源图像生成一张和目标图像姿态一致,而AU不变的人脸图像。在训练阶段通过评估所生成人脸图像的质量,以及重建的目标图像质量,TAE 能够预测出AU和姿态相关的位移场,并学习出与姿态无关的AU特征,以及与AU无关的头部姿态特征。值得一提的是,本文同时采用了一种无监督的注意力机制,用于从输入人脸图像中自动感知出与AU相关的关键局部区域。

本文的主要贡献包括:1)提出了自监督的AU特征学习方法,所提方法能够利用大量无标注人脸视频数据学习出具有判别性的AU特征表示;2)通过合理利用AU的问题定义和先验知识,所提方法能够从视频数据中学习出与头部姿态无关的AU特征表示;3)通过多个FACS数据集的AU检测实验,以及面部表情图像检索实验验证了所提方法的有效性。

相关论文信息:

[1] Yong Li, Jiabei Zeng, Shiguang Shan. Learning Representations for Facial Actions from Unlabeled Videos, IEEE Transactions on Pattern Analysis and Machine Intelligence (T-PAMI). (Accepted on July. 10, 2020)

[2] Yong Li, Jiabei Zeng, Shiguang Shan, Xilin Chen. Self-supervised Representation Learning from Videos for Facial Action Unit Detection, IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR), 2019.

附件下载: